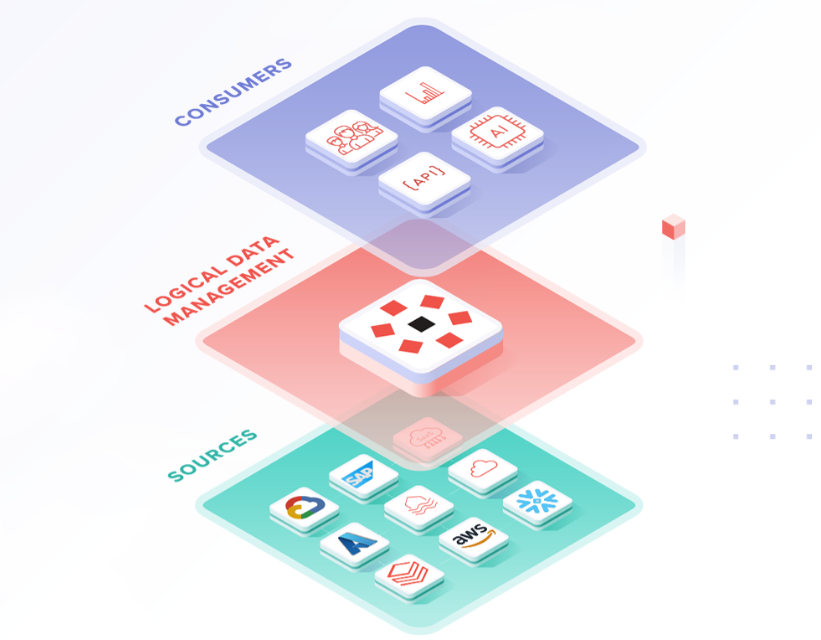

Los ETLs y los Pipelines de datos son como una fábrica, pero en lugar de hacer productos, procesan datos. Estos datos, provenientes de diversas fuentes (bases de datos, archivos, aplicaciones), son la materia prima que alimenta los sistemas de inteligencia de negocios.

¿Qué son?

Los ETLs (Extract, Transform, Load) y los pipelines de datos son conceptos fundamentales en el mundo del procesamiento y análisis de datos. Aunque comparten algunas similitudes, tienen características distintivas:

- ETL (Extraer, Transformar, Cargar): Es un proceso que implica la extracción de datos de diversas fuentes, su transformación para adaptarlos a un formato específico o realizar cálculos, y finalmente la carga de estos datos en un destino, generalmente un almacén de datos o data warehouse.

- Pipeline de datos: Es un conjunto de procesos y herramientas que automatizan el movimiento y transformación de datos entre un punto de origen y un destino. A diferencia de los ETLs, los pipelines pueden manejar datos en tiempo real y son más flexibles en cuanto a las operaciones que pueden realizar.

La importancia de los ETLs y los Pipelines

En un mundo cada vez más data-driven, los ETLs y los pipelines son fundamentales por varias razones:

- Calidad de los datos: Garantizan que los datos sean limpios, consistentes y confiables.

- Eficiencia: Automatizan tareas repetitivas, ahorrando tiempo y recursos.

- Escalabilidad: Se adaptan a volúmenes de datos crecientes y a nuevas fuentes de información.

- Agilidad: Permiten responder rápidamente a las necesidades cambiantes del negocio.

Proceso ETL

El proceso ETL se divide en tres etapas principales:

- Extracción (Extract): Se obtienen los datos de diversas fuentes, que pueden incluir bases de datos, archivos planos, APIs, etc.

- Transformación (Transform): Los datos extraídos se limpian, se formatean y se transforman según las necesidades del negocio. Esto puede incluir operaciones como filtrado, agregación, normalización, etc.

- Carga (Load): Los datos transformados se cargan en el sistema de destino, que suele ser un almacén de datos o data warehouse.

Proceso Pipelines

Los pipelines de datos siguen un flujo más flexible y pueden incluir múltiples etapas:

- Ingesta de datos: Captura de datos de diversas fuentes, que pueden ser en tiempo real o en lotes.

- Procesamiento: Aplicación de diversas transformaciones y análisis a los datos ingresados.

- Almacenamiento: Los datos procesados se almacenan en diversos destinos según las necesidades (bases de datos, data lakes, etc.).

- Análisis y visualización: Muchos pipelines incluyen etapas para analizar los datos procesados y generar visualizaciones o informes.

En el panorama actual del big data y la analítica avanzada, tanto los ETLs como los pipelines de datos juegan un papel crucial en la gestión eficiente de la información. Mientras que los ETLs siguen siendo fundamentales para procesos de carga de datos estructurados en almacenes, los pipelines ofrecen una mayor flexibilidad para manejar flujos de datos complejos y en tiempo real. La elección entre uno u otro dependerá de las necesidades específicas de cada organización, el tipo de datos que manejan y los objetivos de análisis que persiguen. En muchos casos, una combinación de ambos enfoques puede proporcionar la solución más completa y eficaz para el procesamiento de datos en entornos empresariales modernos.